Trong những năm gần đây, trí tuệ nhân tạo (AI) đã tạo ra một cuộc cách mạng mạnh mẽ, đặc biệt với sự xuất hiện của các chatbot có khả năng hiểu và phản hồi văn bản một cách ấn tượng. Tuy nhiên, ranh giới của AI đang tiếp tục được mở rộng với sự ra đời của Multimodal AI (AI đa phương thức) – một bước tiến đột phá hứa hẹn mang lại những khả năng vượt xa việc chỉ xử lý văn bản đơn thuần. Các mô hình AI đa phương thức không chỉ hiểu mà còn có thể liên kết thông tin từ nhiều nguồn đầu vào khác nhau như văn bản, hình ảnh, âm thanh hay thậm chí là dữ liệu từ cảm biến, từ đó cung cấp kết quả thông minh hơn, sâu sắc hơn và ứng dụng rộng rãi hơn trong đời sống và công nghiệp. Sự phát triển này đang định hình lại cách chúng ta tương tác với công nghệ, mở ra kỷ nguyên mới cho trí tuệ nhân tạo.

Multimodal AI là gì? Hiểu rõ khái niệm cốt lõi

Thuật ngữ “multimodal” theo nghĩa đen có nghĩa là sử dụng nhiều chế độ hoặc phương thức. Trong bối cảnh trí tuệ nhân tạo, Multimodal AI đề cập đến khả năng của các mô hình AI trong việc sử dụng nhiều nguồn dữ liệu đầu vào khác nhau, cả trong quá trình huấn luyện và khi tạo ra các kết quả phản hồi. Các chatbot làm mưa làm gió trong năm 2023 thường chỉ có khả năng xử lý một chế độ đầu vào duy nhất, đó là văn bản.

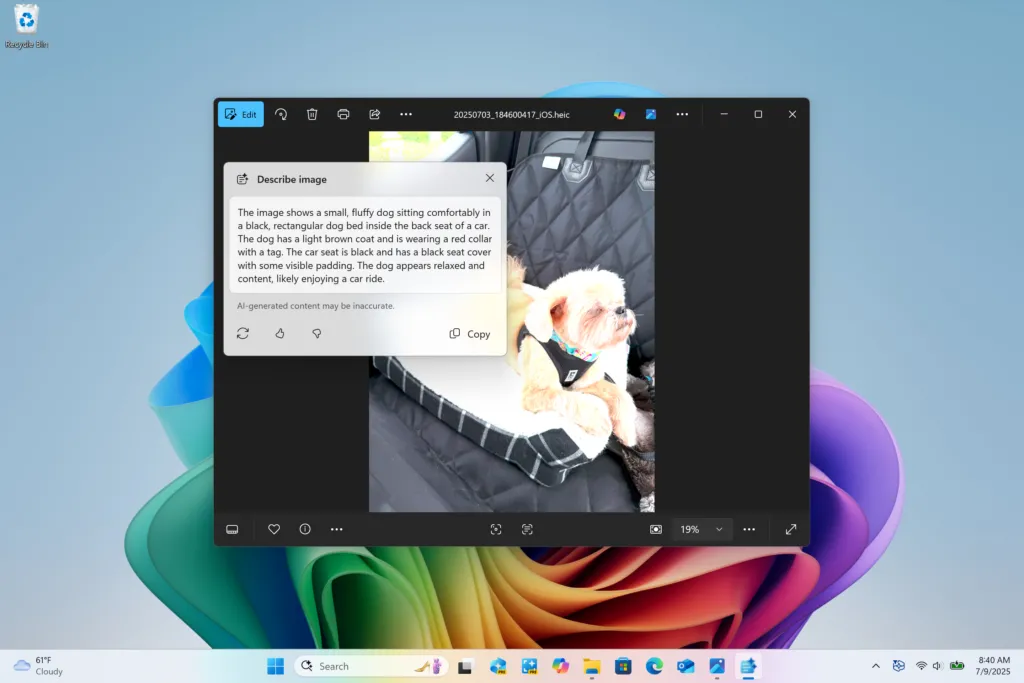

ChatGPT 3.5 cho thấy giới hạn xử lý dữ liệu đầu vào chỉ là văn bản, không hỗ trợ hình ảnh hay video.

ChatGPT 3.5 cho thấy giới hạn xử lý dữ liệu đầu vào chỉ là văn bản, không hỗ trợ hình ảnh hay video.

Ngược lại, AI đa phương thức có thể tiếp nhận hai hoặc nhiều phương thức đầu vào. Điều này áp dụng cho cả việc huấn luyện mô hình và khi người dùng tương tác với nó. Chẳng hạn, một mô hình có thể được huấn luyện để liên kết các hình ảnh nhất định với âm thanh tương ứng bằng cách sử dụng cả tập dữ liệu hình ảnh và âm thanh. Đồng thời, bạn có thể yêu cầu một mô hình kết hợp mô tả văn bản và một tệp âm thanh để tạo ra một hình ảnh đại diện cho cả hai yếu tố.

Các chế độ đầu vào tiềm năng bao gồm văn bản, hình ảnh, âm thanh hoặc thông tin từ các cảm biến như nhiệt độ, áp suất, độ sâu, v.v. Các chế độ này có thể được ưu tiên trong mô hình, trọng số hóa kết quả dựa trên mục đích mong muốn. Multimodal AI là sự phát triển tất yếu của các mô hình đơn phương thức (unimodal models) vốn bùng nổ mạnh mẽ trong năm 2023. Trong khi các mô hình đơn phương thức chỉ có thể nhận lệnh từ một đầu vào duy nhất (như văn bản), thì một mô hình đa phương thức có thể kết hợp nhiều đầu vào như mô tả, hình ảnh và tệp âm thanh để cung cấp kết quả nâng cao hơn.

Tại sao AI đa phương thức vượt trội hơn AI truyền thống?

Multimodal AI là sự tiến hóa logic của các mô hình AI hiện tại, cho phép tạo ra các mô hình “thông thái” hơn. Ứng dụng của các mô hình này rộng lớn hơn nhiều, cả về mục đích sử dụng của người tiêu dùng, trong học máy và triển khai chuyên biệt cho từng ngành.

Hãy tưởng tượng bạn muốn tạo một hình ảnh mới dựa trên một bức ảnh đã chụp. Bạn có thể cung cấp bức ảnh đó cho một mô hình AI và mô tả những thay đổi bạn muốn thấy. Hoặc bạn có thể huấn luyện một mô hình để liên kết âm thanh với một loại hình ảnh cụ thể, hoặc rút ra các mối liên hệ như nhiệt độ. Những loại mô hình này sẽ mang lại kết quả “tốt hơn” ngay cả khi bạn chỉ tương tác với chúng qua văn bản.

Các ví dụ khác bao gồm việc tạo phụ đề video bằng cách sử dụng cả âm thanh và hình ảnh để đồng bộ hóa văn bản với những gì đang diễn ra trên màn hình, hoặc thu thập thông tin tốt hơn bằng cách sử dụng biểu đồ và infographic để củng cố kết quả. Tất nhiên, bạn luôn nên giữ mức độ hoài nghi lành mạnh khi trò chuyện với chatbot.

Multimodal AI đang dần thâm nhập vào công nghệ hàng ngày. Các trợ lý di động có thể được cải thiện đáng kể nhờ việc sử dụng các mô hình đa phương thức, vì trợ lý sẽ có nhiều điểm dữ liệu và ngữ cảnh bổ sung để đưa ra các giả định tốt hơn. Điện thoại thông minh của bạn đã có camera, micro, cảm biến ánh sáng và độ sâu, con quay hồi chuyển và gia tốc kế, dịch vụ định vị địa lý và kết nối internet. Tất cả những điều này đều có thể hữu ích cho một trợ lý trong ngữ cảnh phù hợp.

Ý nghĩa của AI đa phương thức đối với các ngành công nghiệp là vô cùng lớn. Hãy hình dung việc huấn luyện một mô hình để thực hiện một số loại nhiệm vụ bảo trì bằng cách sử dụng nhiều đầu vào để nó có thể đưa ra phán đoán tốt hơn. Liệu một bộ phận có đang quá nóng? Bộ phận đó có bị hao mòn không? Nó có ồn hơn mức bình thường không? Điều này có thể được kết hợp với thông tin cơ bản như tuổi đời của bộ phận và tuổi thọ trung bình của nó, sau đó các đầu vào có thể được trọng số hóa để đưa ra kết luận hợp lý.

Các mô hình AI đa phương thức nổi bật hiện nay

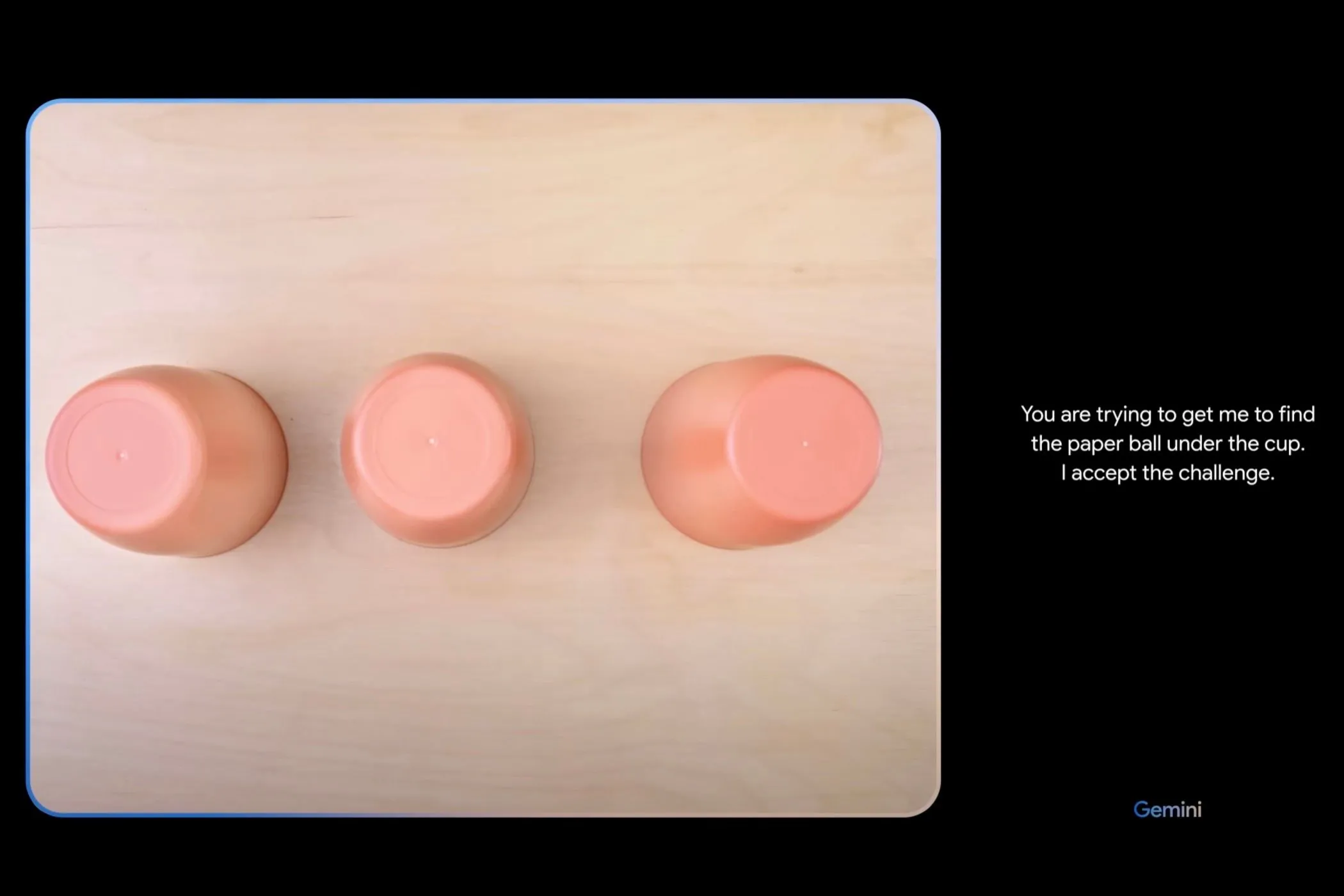

Google Gemini có lẽ là một trong những ví dụ nổi tiếng nhất về AI đa phương thức. Mô hình này không phải không có tranh cãi, với một video trình diễn mô hình được phát hành vào cuối năm 2023 bị những người phản đối gắn mác “giả”. Google đã thừa nhận rằng video đã được chỉnh sửa, rằng kết quả dựa trên hình ảnh tĩnh và không diễn ra theo thời gian thực, và các lời nhắc được cung cấp bằng văn bản chứ không phải nói ra.

Video minh họa khả năng đa phương thức của Google Gemini, cho thấy tương tác với nhiều loại dữ liệu.

Video minh họa khả năng đa phương thức của Google Gemini, cho thấy tương tác với nhiều loại dữ liệu.

Các nhà phát triển đã có thể bắt đầu sử dụng Gemini ngay hôm nay chỉ bằng cách đăng ký API key trong Google AI Studio. Dịch vụ này đã được ra mắt ở cấp độ “miễn phí cho tất cả mọi người” với giới hạn lên tới 60 truy vấn mỗi phút. Bạn sẽ cần hiểu rõ về Python để thiết lập dịch vụ.

Tuy nhiên, Gemini vẫn là một mô hình AI đa phương thức đầy hứa hẹn đã được huấn luyện trên âm thanh, hình ảnh, video, mã và văn bản bằng các ngôn ngữ khác nhau. Nó cạnh tranh trực tiếp với GPT-4 của OpenAI, vốn có thể chấp nhận cả lời nhắc văn bản và hình ảnh. Còn được gọi là GPT-4V (với V là viết tắt của vision – thị giác), mô hình này hiện có sẵn cho người dùng ChatGPT Plus thông qua trang web OpenAI, các ứng dụng di động và API.

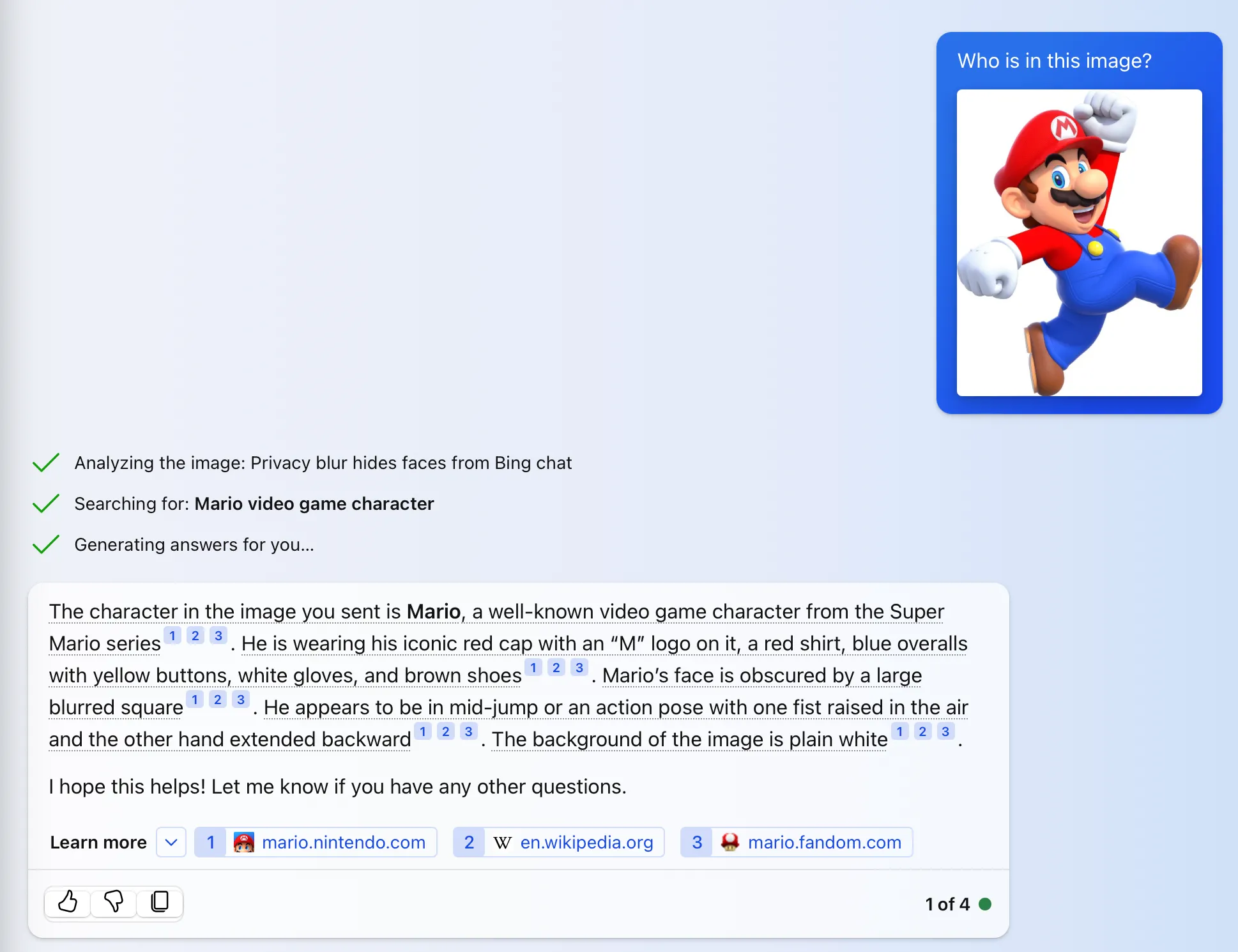

Bạn có thể sử dụng GPT-4V miễn phí qua Bing Chat để tải lên hình ảnh hoặc chụp ảnh từ camera hoặc webcam của thiết bị. Chỉ cần nhấp vào biểu tượng hình ảnh trong hộp “Ask me anything…” để đính kèm hình ảnh vào truy vấn của bạn.

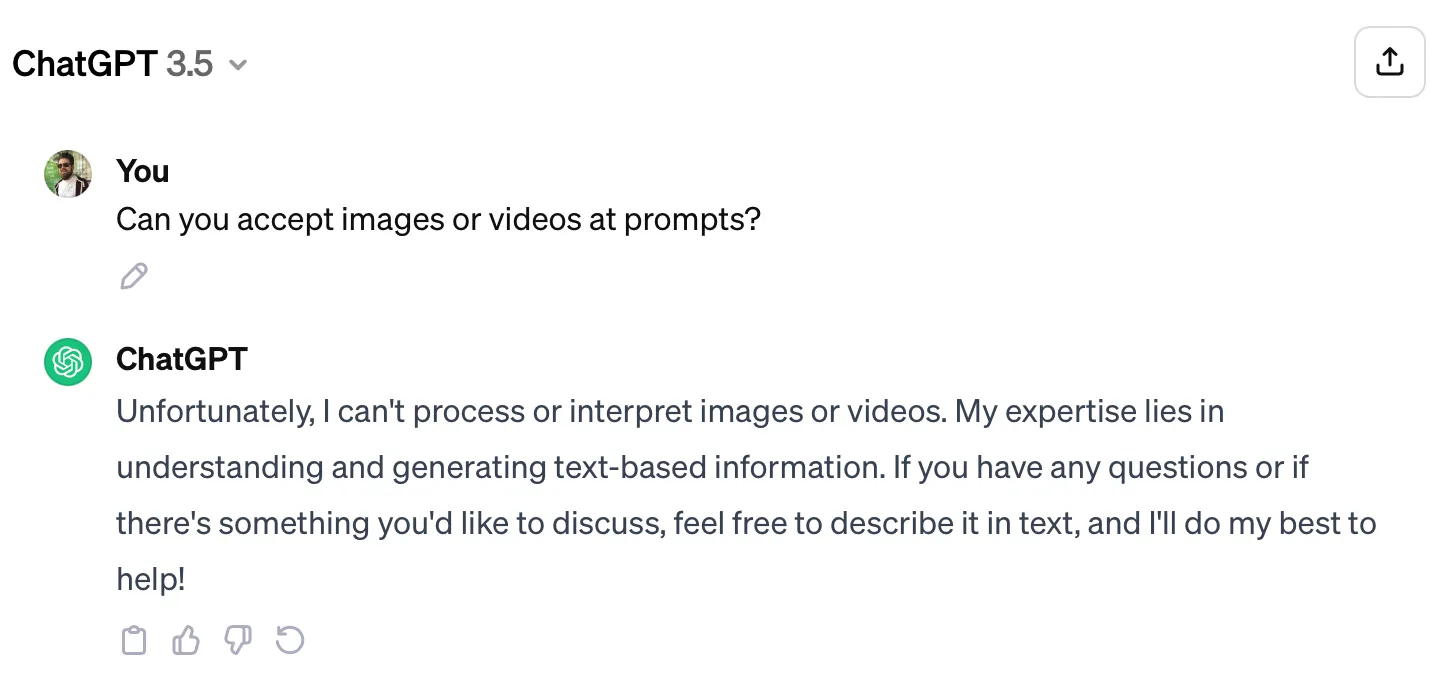

Bing Chat sử dụng AI đa phương thức để nhận diện nhân vật Mario từ hình ảnh tải lên.

Bing Chat sử dụng AI đa phương thức để nhận diện nhân vật Mario từ hình ảnh tải lên.

Các mô hình đa phương thức khác bao gồm Runway Gen-2, một mô hình tạo video dựa trên lời nhắc văn bản, hình ảnh và video hiện có. Hiện tại, kết quả vẫn còn “rất AI”, nhưng như một minh chứng về khái niệm, đây vẫn là một công cụ thú vị để trải nghiệm.

Meta ImageBind là một mô hình đa phương thức khác chấp nhận văn bản, hình ảnh và âm thanh, cùng với bản đồ nhiệt, thông tin độ sâu và quán tính. Rất đáng để xem các ví dụ trên trang web ImageBind để thấy một số kết quả thú vị hơn (chẳng hạn như cách âm thanh nước chảy và một bức ảnh táo có thể được kết hợp thành hình ảnh những quả táo đang được rửa trong bồn rửa).

Kết luận

Việc áp dụng các mô hình AI đa phương thức là một minh chứng rõ ràng cho sự phát triển không ngừng của công nghệ trí tuệ nhân tạo. Mặc dù có thể tạo ra thêm những thuật ngữ công nghệ mới, nhưng giá trị cốt lõi mà AI đa phương thức mang lại là khả năng hiểu và tương tác với thế giới thực một cách toàn diện hơn, vượt xa những giới hạn của các mô hình đơn thuần. Thay vì chỉ xử lý văn bản, những mô hình này có thể kết hợp thông tin từ hình ảnh, âm thanh, video và dữ liệu cảm biến, mở ra vô số ứng dụng tiềm năng trong các thiết bị điện tử tiêu dùng hàng ngày, từ trợ lý di động thông minh hơn đến các công cụ sáng tạo nội dung mạnh mẽ.

Xa hơn nữa, ảnh hưởng của AI đa phương thức còn lan rộng và sâu sắc hơn trong các lĩnh vực chuyên biệt như nghiên cứu y học, phát triển thuốc, phòng ngừa dịch bệnh, kỹ thuật và nhiều ngành công nghiệp khác. Khả năng phân tích và tổng hợp dữ liệu đa dạng sẽ giúp đưa ra những quyết định chính xác hơn, thúc đẩy đổi mới và giải quyết các vấn đề phức tạp mà AI truyền thống khó lòng đáp ứng. Multimodal AI không chỉ là một từ khóa công nghệ mới mà là một bước nhảy vọt, hứa hẹn định hình lại tương lai của trí tuệ nhân tạo và cách chúng ta khai thác sức mạnh của nó. Bạn nghĩ sao về tiềm năng của AI đa phương thức? Hãy chia sẻ ý kiến của bạn trong phần bình luận bên dưới!